概览

产品介绍

Llama 3是Meta公司发布的大型语言模型,于当地时间2024年4月18日对外公布。目前,Llama 3已经开放了80亿(8B)和700亿(70B)两个小参数版本,上下文窗口为8k。与Llama-2相比,Llama-3使用了15T tokens的训练数据,在推理、数学、代码生成、指令跟踪等能力获得大幅度提升。此外,Llama-3还使用了分组查询注意力、掩码等创新技术,帮助开发者以最低的能耗获取绝佳的性能。Llama 3在多种行业基准测试上展现了先进的性能,并提供了包括改进的推理能力在内的新功能。

产品特点介绍

参数规模

Llama 3提供了8B和70B两种参数规模的模型,相比Llama 2参数数量的增加使得植型能够捕捉和学习更复杂的语言槿式

训练数据集

Llama 3的训练数据集比Llama 2大了7倍,包含了超过15万亿个token,其中包括4倍的代码数据,这使得Llama 3在理解和生成代码方面更加出色。

模型架构

Llama 3采用了更高效的分词器和分组查询注意力技术,提高了模型的推理效率和处理长文本的能力。

性能提升

通过改进的预训练和后训练过程,Llama 3在减少错误拒绝率、提升响应对齐和增加模型响应多样性方面取得了进步

安全性

引入了Lama Guard 2等新的信任和安全工具,以及Code shield和CyberSec Eval 2,增强了模型的安全性和可靠性。

多语言支持

Llama 3在预训练数据中加入了超过30种语言的高质量非英语数据,为未来的多语言能力打下了基础。

推理和代码生成

Llama 3在推理、代码生成和指令跟随等方面展现了大幅提升的能力,使其在复杂任务处理上更加精准和高效。

-

亚马逊云科技通过SageMaker JumpStart AI部署Llama 3模型

目前,亚马逊云科技已经支持多种模型的使用,如DeepSeek、Llama 2、Llama 3等,其中Llama 3是专为构建、实验和负责任地扩展生成式人工智能应用程序而设计的,提供8B和70B两种参数。Amazon SageMaker AI简化了Llama 3.3 70B等复杂模型的部署,提供一系列旨在优化性能和成本效率的功能。本文就来详细地带大家来了解一下通过SageMaker JumpStart AI部署Llama 3模型教程。 Llama 3模型: Llama 3 8B非常适合有限的计算能力和资源以及边缘设备 -

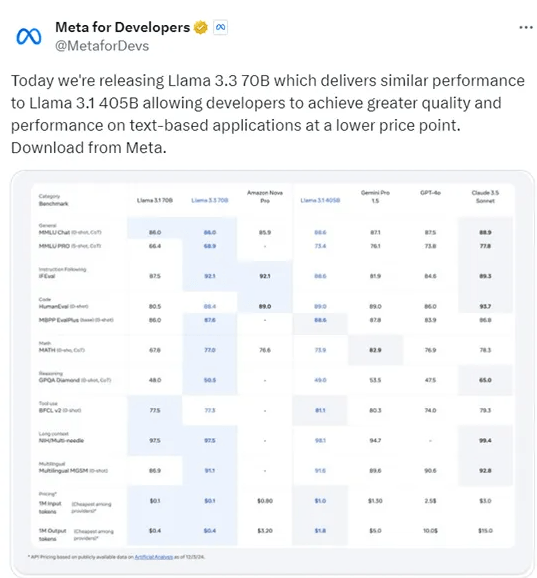

MetaLlama推出最新开源模型Llama 3.3-70B

最近,Meta发布了最新开源模型Llama 3.3-70B。Llama 3.3-70B采用了最新的后训练技术,参数规模仅700亿,能实现和Meta最大Llama模型——4050亿参数的Llama 3.1同样的性能,成本还比Llama 3.1更低。 在一系列行业基准测试中,Llama 3.3-70B的表现超越了谷歌的Gemini 1.5 Pro、OpenAI的GPT-4o以及亚马逊新发布的Nova Pro。Meta发言人表示,该模型应该在数学、常识、指令遵循和应用程序App使用等领域有所提升。 Meta限制了某些开发 -

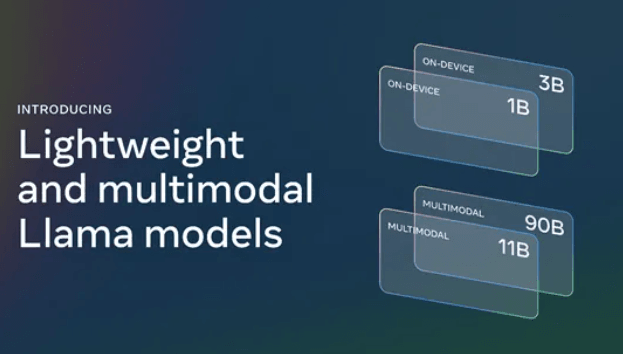

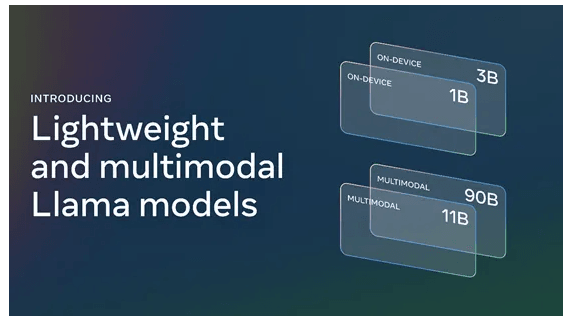

Meta开源多模态模型Llama 3.2

最近,Meta开源了多模态模型Llama 3.2,此次开源的是1B和3B轻量级模型。Meta使用了带有LoRA适配器的量化感知训练和SpinQuant进行了大幅度性能优化,平均减少了41%的内存使用、减少56%的模型规模,但推理效率却提升了2—4倍。 作为整个系列里最轻量级的模型,Llama3.2 1B和3B适合边缘设备和移动应用程序的检索和摘要,可用于个人信息管理和多语言知识检索等,支持128k标记的上下文长度,可在手机、平板电脑等设备中使用。 Llama3.2 1B和3B特点介绍: 1、采用标准的Transfo -

Meta发布多模态Llama 3.2新模型

最近Meta发布了多模态Llama 3.2新模型,能够同时理解图像和文本。此次一共发布了四个版本,分别为Llama 3.2 1B、Llama 3.2 3B、Llama 3.2 90B和Llama 3.2 11B。 其中Llama 3.2 1B和Llama 3.2 3B是整个系列最轻量级的模型,适合边缘设备和移动应用程序的检索和摘要,可用于个人信息管理和多语言知识检索等,支持128k标记的上下文长度,可在手机、平板电脑等设备中使用。而Llama 3.2 90B和Llama 3.2 11B则是Llama首次发布的多模态 -

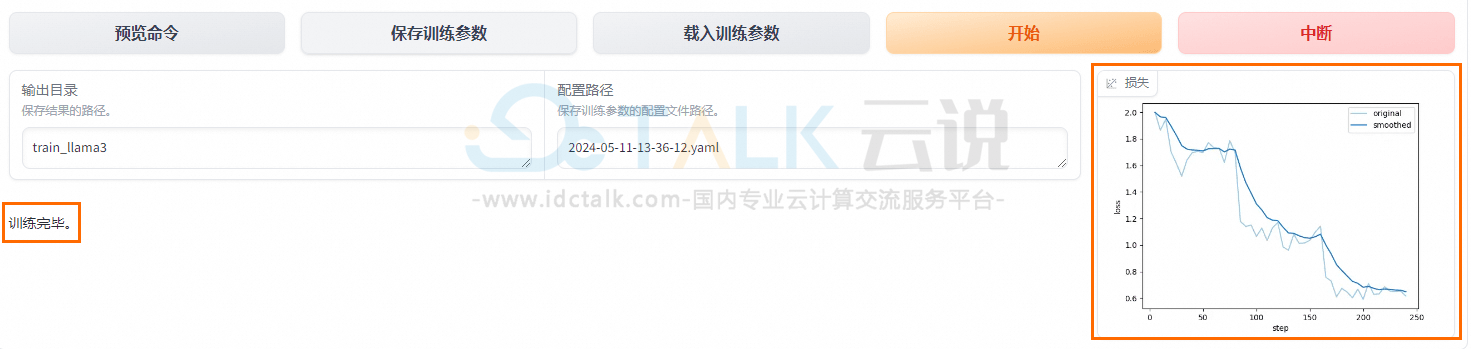

阿里云PAI使用LLaMA Factory微调LlaMA 3模型的教程

LLaMA Factory是什么?LLaMA Factory是一个开源微调框架,旨在简化和优化大规模语言模型的训练和部署。LLaMA Factory集成了业界广泛使用的微调技术,支持通过Web UI界面零代码微调大模型。本文将基于LlaMA 3模型,为大家介绍阿里云PAI使用LLaMA Factory微调LlaMA 3模型的具体操作方法。 点击进入:阿里云官网 前提条件: 1、创建工作空间。 2、创建DSW实例,其中关键参数配置如下: 实例规格选择:建议使用24 GB显存的A10(ecs.gn7i-c8g1.2xl -

Meta发布首个超GPT-4o开源大模型Llama 3.1

最近,Meta宣布推出迄今为止最强大的开源模型——Llama 3.1。Llama 3.1共有8B、70B及405B三种版本,其中405B版本是目前最大的开源模型之一。 Llama 3.1 405B版本在多项测试中一举超越GPT-4o和Claude 3.5 Sonnet,支持128K上下文长度,英语、法语、德语等8种语言,能生成代码、文本、文本摘要等。 Llama 3.1 405B版本现在没有开放还在继续开发中。 Meta更改了开源许可证,这就意味着开发者是可以使用Llama 3.1系列模型的输出去优化其他模型的。这

-

MetaLlama推出最新开源模型Llama 3.3-70B

最近,Meta发布了最新开源模型Llama 3.3-70B。Llama 3.3-70B采用了最新的后训练技术,参数规模仅700亿,能实现和Meta最大Llama模型——4050亿参数的Llama 3.1同样的性能,成本还比Llama 3.1更低。 在一系列行业基准测试中,Llama 3.3-70B的表现超越了谷歌的Gemini 1.5 Pro、OpenAI的GPT-4o以及亚马逊新发布的Nova Pro。Meta发言人表示,该模型应该在数学、常识、指令遵循和应用程序App使用等领域有所提升。 Meta限制了某些开发 -

Meta开源多模态模型Llama 3.2

最近,Meta开源了多模态模型Llama 3.2,此次开源的是1B和3B轻量级模型。Meta使用了带有LoRA适配器的量化感知训练和SpinQuant进行了大幅度性能优化,平均减少了41%的内存使用、减少56%的模型规模,但推理效率却提升了2—4倍。 作为整个系列里最轻量级的模型,Llama3.2 1B和3B适合边缘设备和移动应用程序的检索和摘要,可用于个人信息管理和多语言知识检索等,支持128k标记的上下文长度,可在手机、平板电脑等设备中使用。 Llama3.2 1B和3B特点介绍: 1、采用标准的Transfo -

Meta发布多模态Llama 3.2新模型

最近Meta发布了多模态Llama 3.2新模型,能够同时理解图像和文本。此次一共发布了四个版本,分别为Llama 3.2 1B、Llama 3.2 3B、Llama 3.2 90B和Llama 3.2 11B。 其中Llama 3.2 1B和Llama 3.2 3B是整个系列最轻量级的模型,适合边缘设备和移动应用程序的检索和摘要,可用于个人信息管理和多语言知识检索等,支持128k标记的上下文长度,可在手机、平板电脑等设备中使用。而Llama 3.2 90B和Llama 3.2 11B则是Llama首次发布的多模态 -

Meta发布首个超GPT-4o开源大模型Llama 3.1

最近,Meta宣布推出迄今为止最强大的开源模型——Llama 3.1。Llama 3.1共有8B、70B及405B三种版本,其中405B版本是目前最大的开源模型之一。 Llama 3.1 405B版本在多项测试中一举超越GPT-4o和Claude 3.5 Sonnet,支持128K上下文长度,英语、法语、德语等8种语言,能生成代码、文本、文本摘要等。 Llama 3.1 405B版本现在没有开放还在继续开发中。 Meta更改了开源许可证,这就意味着开发者是可以使用Llama 3.1系列模型的输出去优化其他模型的。这 -

Meta发布了最新大模型Llama 3

随着人工智能大战持续升级,4月19日,全球科技、社交巨头Meta在官网,正式发布了开源大模型——Llama 3。目前,Llama 3已经开放了80亿(8B)和700亿(70B)两个小参数版本,上下文窗口为8k。 Meta表示,通过使用更高质量的训练数据和指令微调,Llama 3比前代Llama 2有了“显著提升”。Llama 3使用了15T tokens的训练数据,在推理、数学、代码生成、指令跟踪等能力获得大幅度提升。此外,Llama 3还使用了分组查询注意力、掩码等创新技术,帮助开发者以最低的能耗获取绝佳的性能。 -

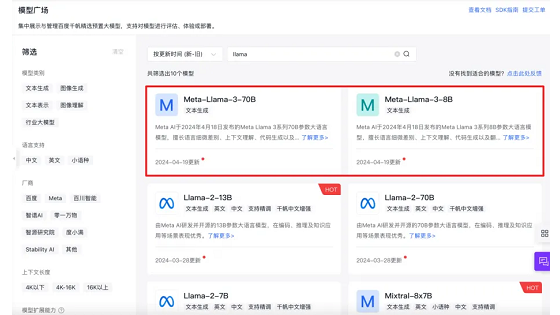

百度智能云:国内首家推出针对Llama3全系列训练方案

4月18日,Facebook母公司Meta重磅推出了号称“史上最强大开源模型”的Llama3。4月19日,百度智能云千帆大模型成为国内首家推出针对Llama3全系列版本的训练推理方案的平台。现已开放邀约测试。 百度智能云千帆大模型平台中各种尺寸模型定制工具千帆ModelBuilder已上架最新Llama 3系列模型,用户在「体验中心」可以随时体验模型效果。同时,开发者可以根据需求上传数据,在千帆ModelBuilder上对部分模型进行精调SFT,提升模型效果,打造您的个人专属模型。 千帆ModelBuilder作为

-

亚马逊云科技通过SageMaker JumpStart AI部署Llama 3模型

目前,亚马逊云科技已经支持多种模型的使用,如DeepSeek、Llama 2、Llama 3等,其中Llama 3是专为构建、实验和负责任地扩展生成式人工智能应用程序而设计的,提供8B和70B两种参数。Amazon SageMaker AI简化了Llama 3.3 70B等复杂模型的部署,提供一系列旨在优化性能和成本效率的功能。本文就来详细地带大家来了解一下通过SageMaker JumpStart AI部署Llama 3模型教程。 Llama 3模型: Llama 3 8B非常适合有限的计算能力和资源以及边缘设备 -

阿里云PAI使用LLaMA Factory微调LlaMA 3模型的教程

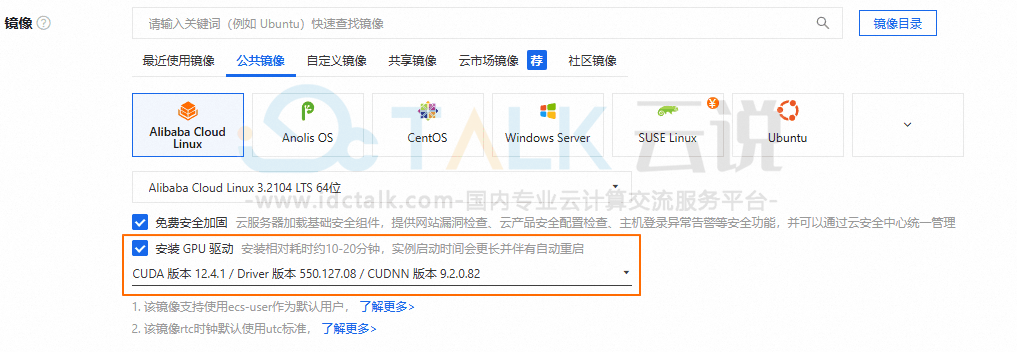

LLaMA Factory是什么?LLaMA Factory是一个开源微调框架,旨在简化和优化大规模语言模型的训练和部署。LLaMA Factory集成了业界广泛使用的微调技术,支持通过Web UI界面零代码微调大模型。本文将基于LlaMA 3模型,为大家介绍阿里云PAI使用LLaMA Factory微调LlaMA 3模型的具体操作方法。 点击进入:阿里云官网 前提条件: 1、创建工作空间。 2、创建DSW实例,其中关键参数配置如下: 实例规格选择:建议使用24 GB显存的A10(ecs.gn7i-c8g1.2xl -

阿里云GPU云服务器部署通义千问QwQ-32B推理模型教程

DeepSeek凭借着自身独特的优势,在短时间内火爆全球,一时间也引发了全球AI模型大爆发。阿里云虽迟但到,于2025年3月发布并开源了通义千问QwQ-32B模型。相较于DeepSeek-R1,QwQ-32B在权威基准测试中表现更优,同时支持消费级显卡本地部署,大幅降低硬件门槛。本文就来为大家介绍在阿里云GPU云服务器实例上部署通义千问QwQ-32B推理模型的详细教程。 一、创建并配置阿里云GPU云服务器 阿里云GPU云服务器是提供GPU算力的弹性计算服务,具有超强的计算能力,适用于AI推理、AI训练、图形图像、科 -

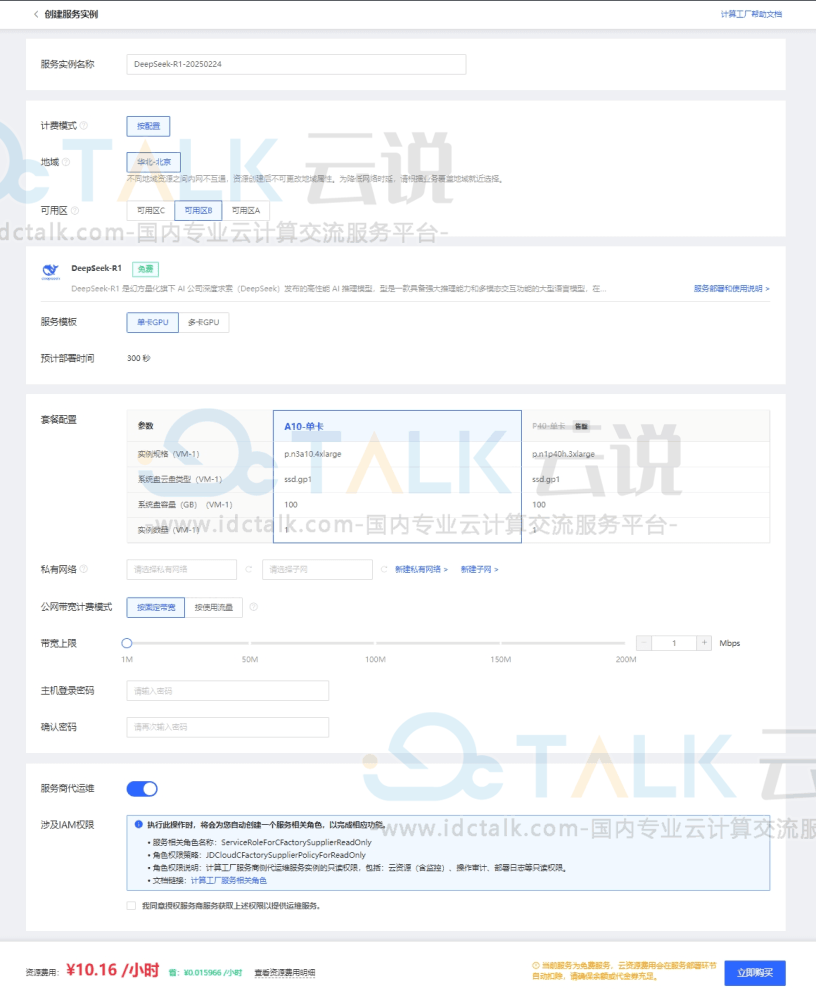

京东云使用Ollama部署DeepSeek-R1教程

DeepSeek-R1是幻方量化旗下AI公司深度求索发布的高性能AI推理模型,是一款具备强大推理能力和多模态交互功能的大型语言模型,在数学、代码、自然语言推理等任务上都有着优异的表现。本文就来为大家介绍一下在京东云上使用Ollama部署DeepSeek-R1教程。 本文使用Ollama部署和运行DeepSeek-R1 1.5B/8B/14B/32B多个版本模型,内置Open WebUI,用户可直接通过IP地址访问Open WebUI,选择DeepSeek-R1模型进行对话。 Ollama:是一个专注于本地部署大型语 -

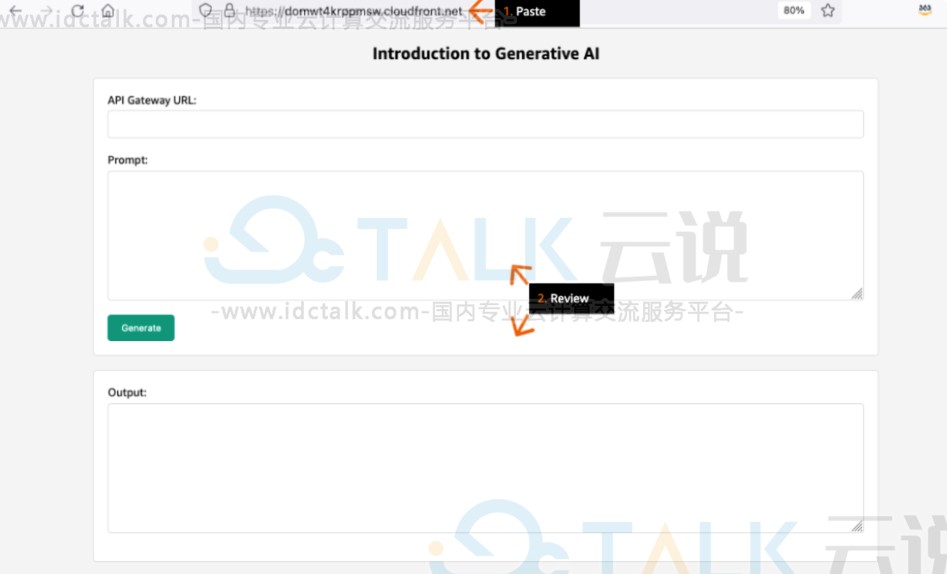

一文教你在亚马逊AWS上搭建生成式AI应用

随着AI的发展,人们已经可以借助现有的云服务开发生成式AI软件应用。哪怕是0基础的新手用户也可以很快上手搭建属于自己的AI应用,本文就以Meta Llama 7B为例,带大家一起来在亚马逊云科技AWS上搭建生成式AI云原生问答机器人,希望可以对大家有所帮助,仅供参考。 本文涉及到亚马逊云服务: 1、Amazon S3 Amazon S3(Simple Storage Service)是一个高度可扩展的对象存储服务,适用于存储和检索任何数量的数据。目前亚马逊官网提供免费套餐包括5GB标准存储、20000个Get请求、 -

亚马逊Amazon SageMaker JumpStart部署Yi-1.5 9B模型

Amazon SageMaker JumpStart是亚马逊AWS推出的一个机器学习(ML)中心,提供了一种高效的方法帮助用户来访问和利用大模型,助力用户轻松启动和开发机器学习项目。目前百川智能和零一万物基础模型现已在SageMaker JumpStart上线。为了大家可以更直观地了解,本文就以零一万物基础模型为例,来为大家具体介绍一下借助Amazon SageMaker JumpStart轻松访问Yi-1.5-9B-Chat模型的教程。 本文涉及到的亚马逊云服务: Amazon SageMaker Amazon

-

书生·浦语怎么样? 书生·浦语开源吗

说到2023年的大模型战场,那只能用神仙打架来形容。单从国内市场来看,据不完全统计,已经诞生了80多个大模型,并且数量还在不断上涨。在国产大模型当中,大家比较熟悉的有文心一言、通义千问、讯飞星火等。接下来给大家介绍的是另一个国产大模型——书生·浦语。 书生·浦语怎么样?书生·浦语由商汤科技、上海AI实验室联合香港中文大学、复旦大学及上海交通大学发布。书生·浦语具有1040亿参数,是在包含1.6万亿token的多语种高质量数据集上训练而成。 书生・浦语联合团队选取了 20 余项评测对其进行检验,其中包含全球最具影响力