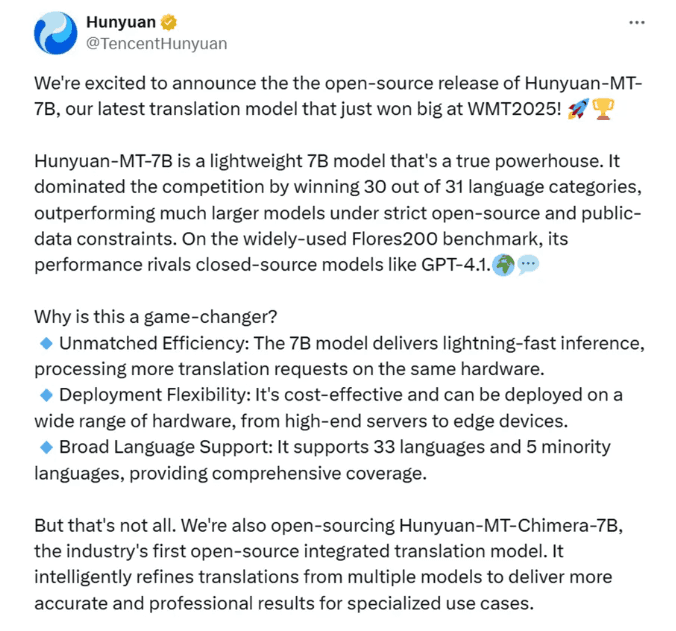

近日,国内云服务器商腾讯云开源了2025年世界机器翻译大会(WMT2025)上斩获佳绩的翻译大模型Hunyuan-MT-7B。该模型总参数量为7B,支持33个语种、5种民汉语言/方言互译,已在腾讯混元官网上线体验入口。

腾讯混元大模型是由腾讯云全链路自研,在高质量的内容创作、数理逻辑、代码生成、多轮对话、图像与视频生产上性能表现优越,处于业界领先水平。

据悉,Hunyuan-MT-7B在中文、英文、法语、德语、马拉地语、爱沙尼亚语、冰岛语、芬兰语、匈牙利语、罗马尼亚语、波斯语、印地语、孟加拉语、泰米尔语、乌尔都语、僧伽罗语等31种主流、小众语言测试中,拿下30个语种第一。

Hunyuan-MT-7B架构介绍:

腾讯混元Hunyuan-MT-7B大模型的发布标志着机器翻译领域进入全新时代,本文将深入解析这一突破性技术如何实现30种语言翻译冠军的卓越表现。

1、基于Transformer的混合专家模型设计

Hunyuan-MT-7B采用基于Transformer的混合专家(Mixture of Experts,MoE)架构,在保持7B参数规模的同时实现接近70B模型的性能表现。

2、多语言注意力机制优化

Hunyuan-MT-7B针对多语言翻译任务优化了注意力机制,引入语言感知的偏置。

Hunyuan-MT-7B阶段训练流程:

1、在通用预训练阶段,腾讯云团队采用了涵盖中文、英文以及少数民族语言的海量数据进行混合训练。

2、监督微调(SFT)是Hunyuan-MT训练过程中的关键环节,旨在通过高质量的标注数据进一步优化模型的翻译性能。第一阶段的目标是增强模型的基础翻译能力和对翻译指令的遵循能力;第二阶段则旨在通过一个更小但更高质量的约268,000对的数据集进一步优化模型的翻译性能。

3、腾讯研究团队采用了GRPO作为强化学习算法,并设计了一个综合的奖励函数。质量感知奖励:为确保强化学习训练期间的翻译质量,采用了两种互补的奖励信号。第一种是XCOMET-XXL,这是一种在翻译评估场景中广泛使用的指标,与人类评估具有高度相关性。第二种奖励则利用DeepSeek-V3-0324进行评分,提示语从GEMBA框架中改编而来。

4、在强化训练的后期阶段,模型倾向于生成重复的输出,这可能导致训练崩溃。为缓解这一问题,团队实施了一种重复检测机制,当检测到重复模式时,将应用惩罚,以维护输出的多样性和训练的稳定性。

腾讯云混元Hunyuan-MT-7B不仅是一个技术产品,更是推动整个机器翻译领域发展的重要力量,其开源策略将加速人工智能翻译技术的普及和应用,为打破语言障碍、促进全球交流做出重要贡献。