2000 年,亚马逊带着 " 网络就是计算机 " 疑惑,懵懂地叩开了云计算的大门,在其电子商务网站初尝试后,成功推出 S3(Simple Storage Service)和 EC2(Elastic Cloud Computer)产品,自此高歌猛进,将云计算正式带入大众视野,站到了云计算领域的最高处。

2023 年 11 月 28 日,在美国拉斯维加斯举办的亚马逊云科技 re:Invent 2023 大会上,站在竞争更为激烈的算力先行、数据为王的生成式 AI 风口,亚马逊云科技首席执行官 Adam Selipsky 在现场左手携英伟达黄教主,右手带 OpenAI 最强竞争对手 Anthropic 联合创始人 Dario Amodei,发布了系列 " 王炸 " 产品,再次赢得了无数掌声,成为 AI 领域不容忽视的存在。

17 年磨一剑,程序员编程利器 Amazon Q 面世!

这场时长 2.5 小时的发布会上,Adam Selipsky 从「应用 - 存储 - 基础架构」三层架构切入,向众人揭开了亚马逊云科技的生成式 AI 技术栈。

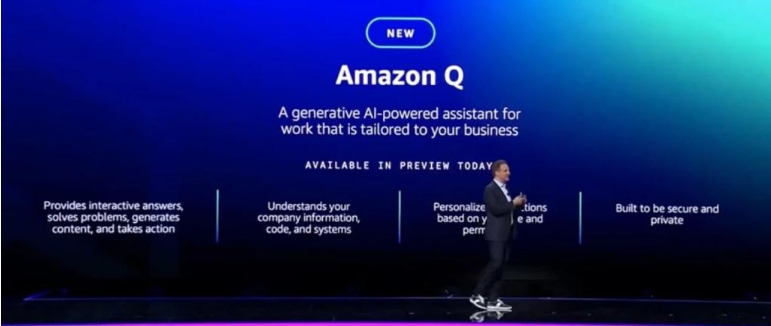

在距离开发者最近的应用层,亚马逊云科技和微软、Google 之间的竞争,正在从彼时的云计算领域,延展到当下的生成式 AI 领域。这一次在前有 ChatGPT、Bard 的夹击下,亚马逊云科技于本次大会上推出了一个名为 Amazon Q 的 AI 助手与其 " 兵戎相见 "。

和前二者有所不同的是,Amazon Q 是由亚马逊云科技 17 年来积累的知识和经验训练而成,目标更为精准,主要是面向企业级用户的工具。用户可以通过亚马逊云科技管理控制台、文档页面、IDE、Slack 或其他第三方对话应用程序的聊天界面访问 Amazon Q。

过往开发者经常性需要花费数小时进行应用程序维护和升级,而用于编写代码或构建新应用程序的时间非常有限。虽然这些升级对于应用程序安全性非常重要,并能提升性能,但它们通常需要开发者花费数月或数年来检查每一行代码。

时下,开发者可以借助 Amazon Q 代码转换功能,能够减少很多繁琐工作,将所需的时间从几天缩短到几分钟。开发者只需要在 IDE 中打开代码,告诉 Amazon Q 进行 " 转换 ",然后 Amazon Q 会分析代码库、识别和更新其依赖项、生成新的代码语言、纳入最新的安全性和性能增强功能,并进行测试以验证应用程序能够运行。

在亚马逊云科技分享的最新实践中,由 5 名亚马逊开发者组成的小团队基于 Amazon Q 代码转换功能,在短短两天内将 1000 个生产应用程序从 Java 8 升级到 Java 17。每个应用程序升级的平均时间不到 10 分钟。Amazon Q 代码转换目前支持从 Java 8 到 Java 17 的语言升级,.NET 框架到跨平台 .NET 的升级即将推出,更多代码转换功能也将陆续推出。

与此同时,开发者还可以使用 Amazon Q 通过问答聊天来理解具体的程序代码逻辑、加速功能开发等等。

从企业层面来看,Amazon Q 可以根据企业自身的信息存储库、代码和企业系统的见解,让员工在其中提出与其公司特定的问题,同时兼容 40 多个流行数据源的内置连接器,如 Amazon S3、Dropbox、Confluence、Google Drive、Microsoft 365、Salesforce 等,方便企业根据既有的人员、角色和权限对每个用户交互进行个性化定制。

之所以可以实现这样的功能,是因为 Amazon Q 采用了 " 数据优先 " 的方法,旨在集成到现有工作流程中,并可以插入公司内部数据库中。而对于众人都颇为关心的安全问题,亚马逊此次主打的便是「隐私与安全」,其做出承诺,「用户的内容绝不会用于训练 Amazon Q 的底层模型」。

不过,需要注意的是,ChatGPT 和 Bard 均可免费向个人用户提供,但 Amazon Q 是专门针对付费企业,尤其是那些已经使用其他亚马逊云科技服务的企业。当前亚马逊云科技已经将 Amazon Q 引入专为云构建的统一 BI 服务 Amazon QuickSight(预览版)、云联络中心 Amazon Connect(正式版)中,未来也即将在 Amazon Supply Chain 中推出。

黄教主亲身支持,现场官宣英伟达重磅合作

在主题演讲中,亚马逊云科技 CEO Adam Selipsky 邀请上老朋友英伟达 CEO 黄仁勋,黄教主的出现也让现场进入了一个小高潮。

两人共同宣布了亚马逊云科技与英伟达宣布扩大战略合作,将联合推出先进的基础设施、软件及服务,推动客户在生成式 AI 的创新,这些合作包括:

亚马逊云科技推出首款结合 NVIDIA Grace Hopper Superchip 与 Amazon UltraCluster 扩展功能的云 AI 超级计算机;

NVIDIA DGX Cloud 率先配备 NVIDIA GH200 NVL32,并首次在亚马逊云科技上提供此 AI 训练即服务;

英伟达和亚马逊云科技在 Project Ceiba 上合作,打造全球最快的 GPU 驱动 AI 超级计算机以及最新的 NVIDIA DGX Cloud 超级计算机,用于英伟达的 AI 研发以及自研模型开发服务;

配置 NVIDIA GH200、H200、L40S 以及 L4 GPU 等芯片的全新 Amazon EC2 实例,大幅提升生成式 AI、HPC 高性能计算、设计以及模拟类工作负载的性能;

在亚马逊云科技上运行的英伟达软件,包括 NeMo LLM 框架、NeMo Retriever 以及 BioNeMo,加速自研模型、语义检索、新药研发等应用的生成式 AI 发展。

早在十三年前,亚马逊云科技与英伟达就已经开始合作,共同推出全球首个配置 GPU 的云端实例。

黄教主在现场表示:「生成式 AI 正改变各种云端负载,为多元内容创作在底层注入加速计算动能。我们共同目标是为每个客户提供具有成本效益、先进生成式 AI,为此英伟达与亚马逊云科技在整个计算堆栈展开合作,横跨 AI 基础设施、加速库(acceleration libraries)、基础模型以及生成式 AI 服务。」

大模型技术引领的生成式 AI 技术,也让全球共同迎来新的技术新浪,企业希望找到新的增长引擎。亚马逊云科技不仅在底层云服务上持续提供稳定的服务,也为模型训练和应用端大规模的推理提供了齐全的计算、高速联网和高性能存储选项。

两大 " 王炸 " 芯片来袭,数周内训练出 3000 亿个参数的 LLM

在这算力先行的时代,亚马逊云科技也做了两手准备,除了和英伟达的长期合作外,Adam Selipsky 最新推出了自家新版本的定制微处理器 Amazon Graviton4 和用于训练神经网络的专用芯片 Amazon Trainium2,为机器学习 ( ML ) 训练和生成式人工智能 ( AI ) 应用等广泛的工作负载提供更高性价比和能效。

Graviton4:亚马逊云科技性能最强、能效最高的自研芯片

据官方透露,亚马逊云科技在全球规模化提供的基于 Graviton 的 Amazon EC2 实例种类达 150 多个,已经构建的 Graviton 处理器数量超过 200 万个,并拥有超过 50,000 客户。

时下最新带来的 Graviton 4 处理器,基于 ARM Holdings 的微处理器知识产权构建,与基于较旧的 x86 芯片标准的 Intel 和 Advanced Micro Devices 的处理器竞争。亚马逊云科技表示,相比上一代 Graviton 3 处理器,Graviton 4 性能提升 30%,独立核心增加 50% 以上,内存带宽提升 75% 以上。与此同时,它还进一步通过高速物理硬件接口的完全加密提升了安全性。

Graviton 4 处理器旨在运行更传统的工作负载,包括数据库、数据分析、网络服务器、批处理、广告服务、应用服务器以及微服务等。

目前 Amazon EC2 R8g 内存优化性实例将采用最新的 Graviton4 预览版,未来几个月推出正式可用版,提升客户运行高性能数据库、内存缓存、大数据分析等工作负载的效率。

Trainium2:高性能、高速度、低成本训练模型

如今日益增加的生成式 AI 应用背后的基础模型和大语言模型需要使用海量数据集进行训练。这些模型通过创造文字、音频、图片、视频、甚至软件代码等大量新的内容,帮助客户重构用户体验。当今最先进的基础模型和大语言模型通常包含数千亿甚至数万亿个参数或变量,需要能够支持上万机器学习芯片进行扩展的可靠高性能计算能力。

Trainium 2 便是一款专为以高性能训练具有数万亿个参数或变量的基础模型和大语言模型而构建的芯片。与第一代 Trainium 芯片相比,Trainium2 性能提升多达 4 倍,内存提升 3 倍,并能在 EC2 UltraClusters 中部署多达 100,000 个芯片,可以在极短的时间训练基础模型(FMs)和大语言模型(LLMs),同时能效提升多达 2 倍。

亚马逊云科技正在其 Amazon EC2 Trn2 实例中提供最新的 Trainium2。其表示,该实例提供 16 个协同运行的 Trainium 加速芯片。Trainium2 实例致力于为客户在新一代 EC2 UltraClusters 中扩展多达 100,000 个 Trainium2 加速芯片,并与 Amazon Elastic Fabric Adapter(EFA)PB 级网络互联,提供的算力高达 65 exaflops,客户可按需获得超级计算级别的性能。有了这个级别的规模,用户可在数周而非数月就能训练完成一个具有 3 千亿参数的大语言模型。通过以显著降低的成本提供最高横向扩展的模型训练,Trainum2 实例可以帮助客户解锁并加速生成式 AI 的新一轮创新。

生成式 AI 平台 Amazon Bedrock 全新升级,联手 OpenAI 最强竞争对手

作为一项完全托管的服务,生成式 AI 平台 Amazon Bedrock 使用单个 API 提供来自 AI21 Labs、Anthropic、Cohere、Meta、Stability AI 和 Amazon 等领先人工智能公司的高性能基础模型(FM),以及构建生成式人工智能应用程序所需的一系列广泛功能,在维护隐私和安全的同时简化开发。它最初是在今年 4 月首次推出,9 月全面开放。

此次大会上,亚马逊对 Amazon Bedrock 进行了全新的功能升级。Amazon Bedrock 现在提供三个新的定制功能,允许客户根据其特定需求和数据进一步定制生成式 AI 模型:

其一,可以使用客户自己的数据中的标记示例来微调模型,以教授模型领域、产品、服务或其他特定于业务的信息。

其二,知识库的检索增强生成 ( RAG ) 功能,允许模型在响应时从客户的内部数据源检索和考虑附加信息。

其三,持续预训练,它使用大量客户的未标记数据来提高模型在其行业或领域的知识和推理能力。

Agents for Amazon Bedrock 现全面推出,改进了编排控制和推理可见性

" 我们希望你能够使用 Bedrock 完成预订旅行、提交保险索赔、部署软件等操作……这通常需要在组织中运行的多个系统之间进行协调,"Selipsky 说。" 这就是为什么几个月前,我们推出了 Agents for Amazon Bedrock,今天我很高兴地宣布,这项强大的功能现已全面推出。"

作为开发者,你可以使用 Agents for Amazon Bedrock 新的跟踪功能来追踪执行计划时使用的推理,也能查看编排过程中的中间步骤,并使用此信息来排除问题。

此外,你还可以访问和修改 Agent 自动创建的提示,以进一步增强最终用户体验。以及可以更新此自动创建的提示(或提示模板),以帮助 FM 增强编排和响应,从而更多地控制编排过程。

Guardrails for Amazon Bedrock 预览版推出

更进一步,Selipsky 还宣布推出 Amazon Bedrock Guardrails,作为进一步提高人工智能模型安全性的一种方式。Guardrails 允许客户根据其负责任的人工智能政策配置模型来避免某些主题、词语或响应。

" 我们正在以一种根本不同的方式来探讨生成式人工智能的整个概念,因为我们了解如何重新发明如何使用这项技术进行构建,"Selipsky 说。

联手 Claude 模型背后的 Anthropic,主打 AI 安全之战

值得关注的是,与亚马逊云科技志同道合的 Anthropic,继 9 月官宣战略合作共同推进生成式 AI 发展后,在此次 re:Invent 上,Anthropic 首席执行官兼联合创始人 Dario Amodei 与 Adam 共同登台亮相也赢得了阵阵喝彩。

这个由 OpenAI 核心人员创立的公司自诞生之日起就被冠以「OpenAI 最强竞争对手」的称号,如此打擂台也与此次刚告一段落的 OpenAI 乱局之争有着莫大的关系——「AI 安全」。而在现场,Dario Amodei 再一次强调了「安全是始终不变的核心」。与此同时,Amodei 还带来最新发布的 Claude 2.1 的信息:幻觉减少了近一半,可以为专业级用户一次性消化多达 20 万个 Token,比 GPT-4 企业版要高出许多。

从应用、存储到芯片,亚马逊云科技正在重构基础设施。除了上述的重磅发布之外,还有着非常多的大招,比如存储的重大更新:Adam 一登台就先带来的高性能、低延迟的对象存储服务 Amazon S3 Express One Zone,能够提供比 Amazon S3 标准版快 10 倍的性能,同时以个位数的毫秒级延迟每秒处理数十万个请求。