亚马逊云科技作为一家优质的云计算平台,为用户提供服务器、数据库、云存储等多种热门服务,亚马逊服务器目前主要提供云服务器(Amazon EC2)和VPS服务器(Amazon Lightsail),本文就以亚马逊服务器Amazon EC2为例,为大家详细介绍一下亚马逊服务器部署Qwen-7B-Chat大模型教程,仅供参考。

一、创建Amazon EC2服务器

Qwen-7B-Chat大模型也就是阿里云推出的通义千问系列模型中的一个,具有70亿参数规模,是基于Transformer架构构建的。要部署这个模型,用户需要先拥有一个Amazon EC2。

目前亚马逊云科技官网提供免费Amazon EC2服务,可免费试用12个月,免费配置为1核1G、30GB SSD,新用户注册亚马逊云科技账户,即可免费试用。

领取地址:亚马逊Amazon EC2

相关推荐:《如何注册亚马逊AWS账号》

1、进入亚马逊云科技官网,注册并登录账号。

2、进入控制台,选择Amazon EC2,点击“启动实例”。

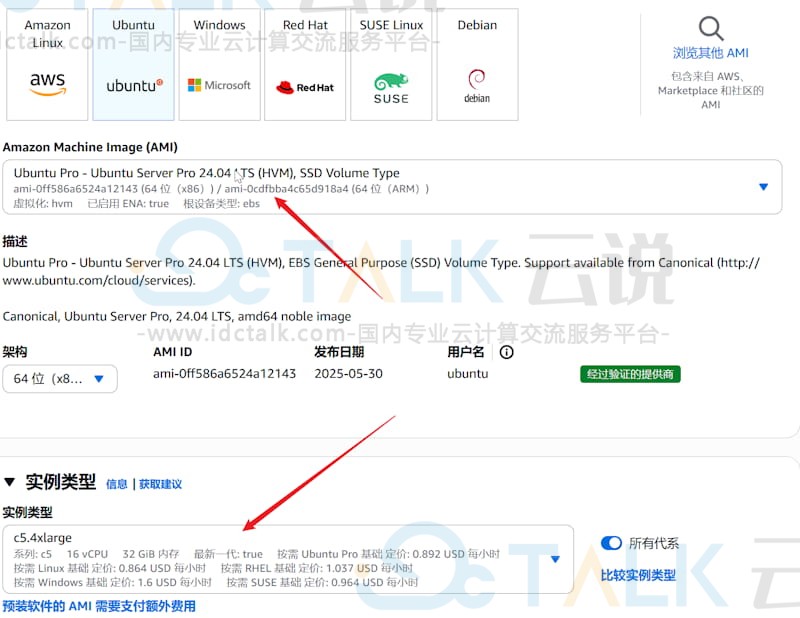

3、进入实例创建页面,选择实例类型,本文选择t2.micro实例。

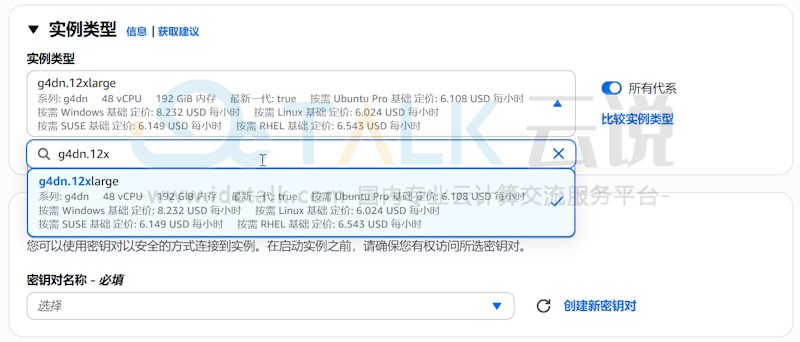

4、建议选择配置较高的实例,根据Qwen-7B-Chat大模型的配置要求,至少需要16G内存、100GB的磁盘。

同时在下面的磁盘大小默认是8GB,需要增加到100GB。配置AWS EC2服务器的时候,安全组要常规放行,包括要放行一个7860端口,7860端口用于访问WebUI页面。

二、Amazon EC2部署Qwen-7B-Chat大模型

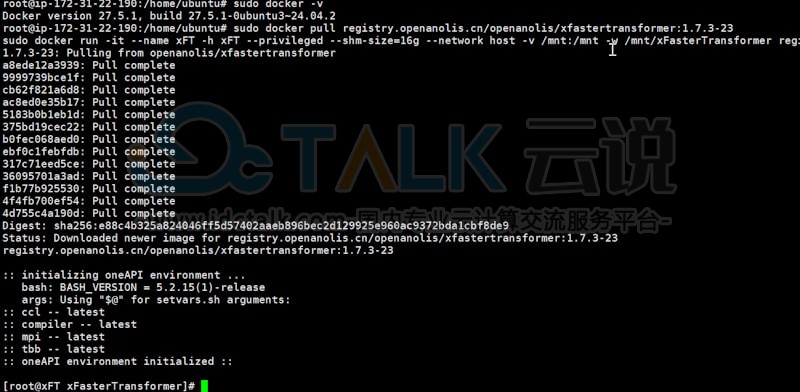

1、安装并启动Docker容器,同时检查容器是否安装。

sudo docker -v

2、获取并运行Intel xFasterTransformer容器,如图所示:

sudo docker pull registry.openanolis.cn/openanolis/xfastertransformer:1.7.3-23

sudo docker run -it --name xFT -h xFT --privileged --shm-size=16g --network host -v /mnt:/mnt -w /mnt/xFasterTransformer registry.openanolis.cn/openanolis/xfastertransformer:1.7.3-23

注:后续操作都需要在容器中运行,如果退出了容器,可以通过以下命令启动并再次进入容器的Shell环境。

sudo docker start xFT

sudo docker exec -it xFT bash

3、在容器中安装依赖软件。

yum update -y

yum install -y wget git git-lfs vim tmux

4、启用Git LFS,下载预训练模型需要Git LFS的支持。

git lfs install

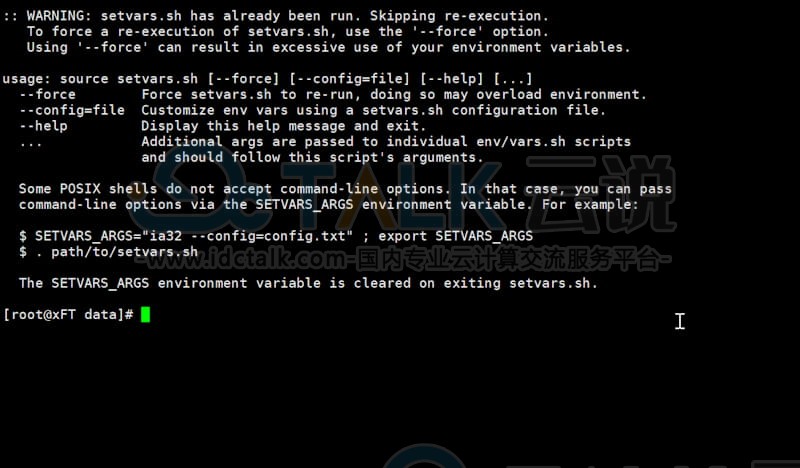

5、创建并进入模型数据目录。

mkdir /mnt/data

cd /mnt/data

6、创建一个tmux session。

tmux

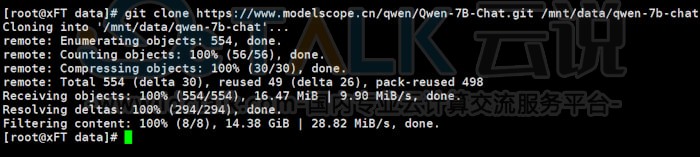

7、下载Qwen-7B-Chat预训练模型,等待下载完成即可。

git clone https://www.modelscope.cn/qwen/Qwen-7B-Chat.git /mnt/data/qwen-7b-chat

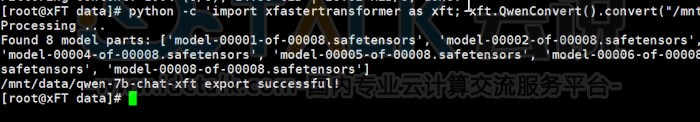

注:由于下载的模型数据是HuggingFace格式,需要转换成xFasterTransformer格式。生成的模型文件夹为/mnt/data/qwen-7b-chat-xft。

python -c 'import xfastertransformer as xft; xft.QwenConvert().convert("/mnt/data/qwen-7b-chat")'

转换成功以后,就可以运行模型对话,可以使用命令界面:

cd /root/xFasterTransformer/examples/pytorch

OMP_NUM_THREADS=$(($(lscpu | grep "^CPU(s):" | awk '{print $NF}') / 2)) LD_PRELOAD=libiomp5.so numactl -C $(seq -s, 0 2 $(($(lscpu | grep "^CPU(s):" | awk '{print $NF}') - 2))) -m 0 python demo.py -t /mnt/data/qwen-7b-chat -m /mnt/data/qwen-7b-chat-xft -d bf16 --chat true

在运行后可以看到命令对话提示。