DeepSeek和Open WebUI都是当前非常火热且备受关注的开源项目,它们的结合可以为企业和个人构建专属AI应用提供了强大的技术支撑。为方便大家了解,本文就以国内云服务器商七牛云为例,将DeepSeek-R1私有部署与Open WebUI相结合,从而高效地构建专属的AI应用。

一、购买七牛云服务器

1、进入七牛云官网,注册并登录账号。

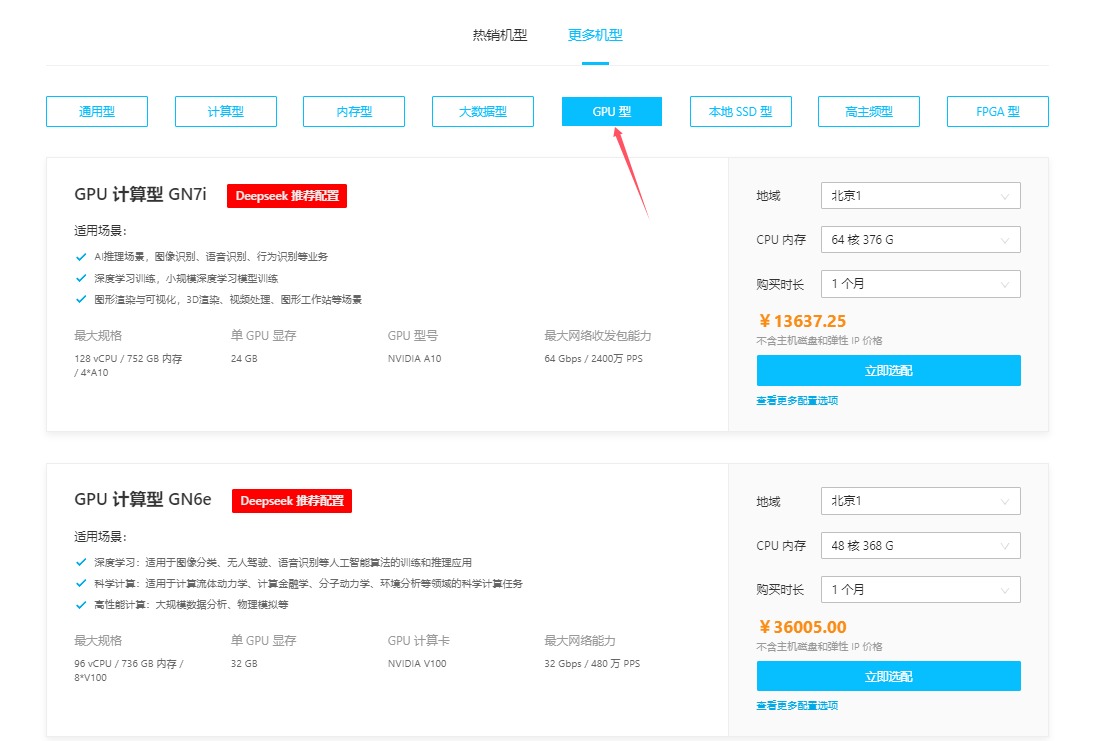

2、选择“产品”>“云基础资源”>“云服务器”。

3、在以下页面热门产品规格中,建议选择“GPU型”以加速模型推理。

《点击进入官网选购》

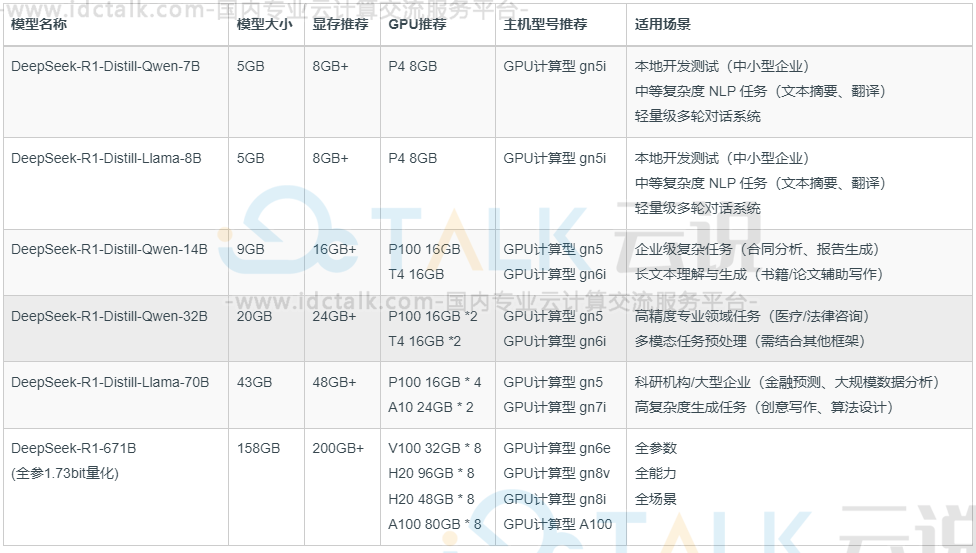

用户可以根据下方模型列表选购所需要的云服务器。

注:软件环境:安装Docker、NVIDIA驱动、CUDA等必要软件,并确保环境变量配置正确。

二、利用DeepSeek-R1+Open WebUI构建AI应用

DeepSeek-R1作为一款功能强大的大型语言模型,其私有化部署方案能够满足企业对数据安全、模型定制和成本控制的迫切需求。

DeepSeek-R1私有部署的优势:

- 数据安全可控:私有化部署将数据和模型完全掌控在企业内部,有效避免了数据泄露的风险,满足金融、医疗等对数据安全要求严格的行业需求。

- 模型定制化:企业可以根据自身业务场景和数据对DeepSeek-R1进行微调,打造更精准、更高效的专属模型,提升业务价值。

- 私有知识库:私有化部署允许企业将内部知识库与DeepSeek-R1集成,使模型能够访问和利用企业独有的数据和信息,生成更精准、更符合业务需求的输出结果。

- 成本优化:私有部署避免了按量付费的模式,长期使用成本更低,尤其适合高频次、大规模使用大模型的场景。

Open WebUI为用户提供了直观易用的交互界面,极大地降低了大语言模型的使用门槛。

1、获取模型

七牛云提供Docker镜像一键部署Open WebUI+DeepSeek-R1模型,用户可以根据需求部署DeepSeek 7B/8B/14B/32B/70B版本。

# 启动镜像 将会从指定服务器中下载镜像 并运行一个容器 在浏览器地址栏输入<IP>:8000即可访问到open-webui的网页界面

# 初次运行容器时 需要等待模型下载完毕后 才能开始正常对话

# 7B模型

docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek7b_ollama_lite_openwebui:0.2.0# 8B模型

docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek8b_ollama_lite_openwebui:0.2.0# 14B模型

docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek14b_ollama_lite_openwebui:0.2.0# 32B模型

docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek32b_ollama_lite_openwebui:0.2.0# 70B模型

docker run --gpus all -p 8000:8080 -it registry-aigc.qiniu.io/miku-aigc/deepseek70b_ollama_lite_openwebui:0.2.0

2、访问WebUI

通过浏览器访问Open WebUI界面,切换模型为DeepSeek-R1,即可体验DeepSeek-R1的强大功能。

- 模型微调:根据业务需求,使用企业自有数据对DeepSeek-R1进行微调,提升模型在特定场景下的表现。

- 私有知识库集成:将企业内部知识库与DeepSeek-R1集成,使模型能够访问和利用企业独有的数据和信息。

- 性能优化:根据实际使用情况,调整模型参数、优化服务器配置,提升系统整体性能。

3、部署完成以后,下面用户就可以根据自身的需求去部署个人专属AI应用了。

4、进入AI应用创建区,选择需要创建的应用。

5、根据用户需求来配置AI应用,配置完成后进行测试。

6、确认无误后,点击“发布”即可完成构建专属AI应用操作。

相关推荐: