ChatGPT是OpenAI发布的一种基于深度学习的聊天机器人模型,基于GPT系统大模型构建,可以用于生成自然的对话回复。ChatGPT目前已经支持在多种云服务器上部署,其中就包括亚马逊云科技、阿里云、腾讯云等,本文就以亚马逊云科技为例,为大家介绍在亚马逊Amazon EC2上快速部署ChatGPT模型,仅供参考。

本文涉及到的亚马逊云服务:Amazon EC2

Amazon EC2(AWS EC2)是一种弹性、安全、高可用的云服务器,提供超过500种类型和大小的计算实例,几乎可以满足各种工作负载和业务的需求。

现亚马逊云科技官网提供免费AWS EC2试用服务,可免费试用12个月,免费套餐配置为性能可突增的CPU、1核1GB内存、30GB SSD、多操作系统可选,包括每月750个小时t2.micro或t3.micro实例,公有IPv4地址使用。

点击获取:亚马逊免费Amazon EC2

相关推荐:《如何注册亚马逊AWS账号》

一、创建亚马逊Amazon EC2

1、进入亚马逊云科技官网,注册并登录账号。

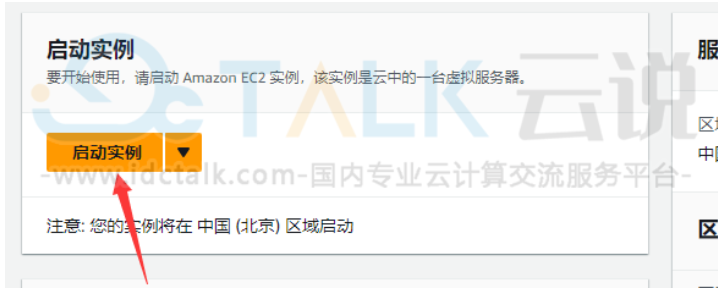

2、进入AWS EC2控制台,创建实例。

3、用户可以根据自身需求和使用场景来选择适合的实例类型。

4、根据提示来配置实例。

5、一切准备就绪后,启动实例。

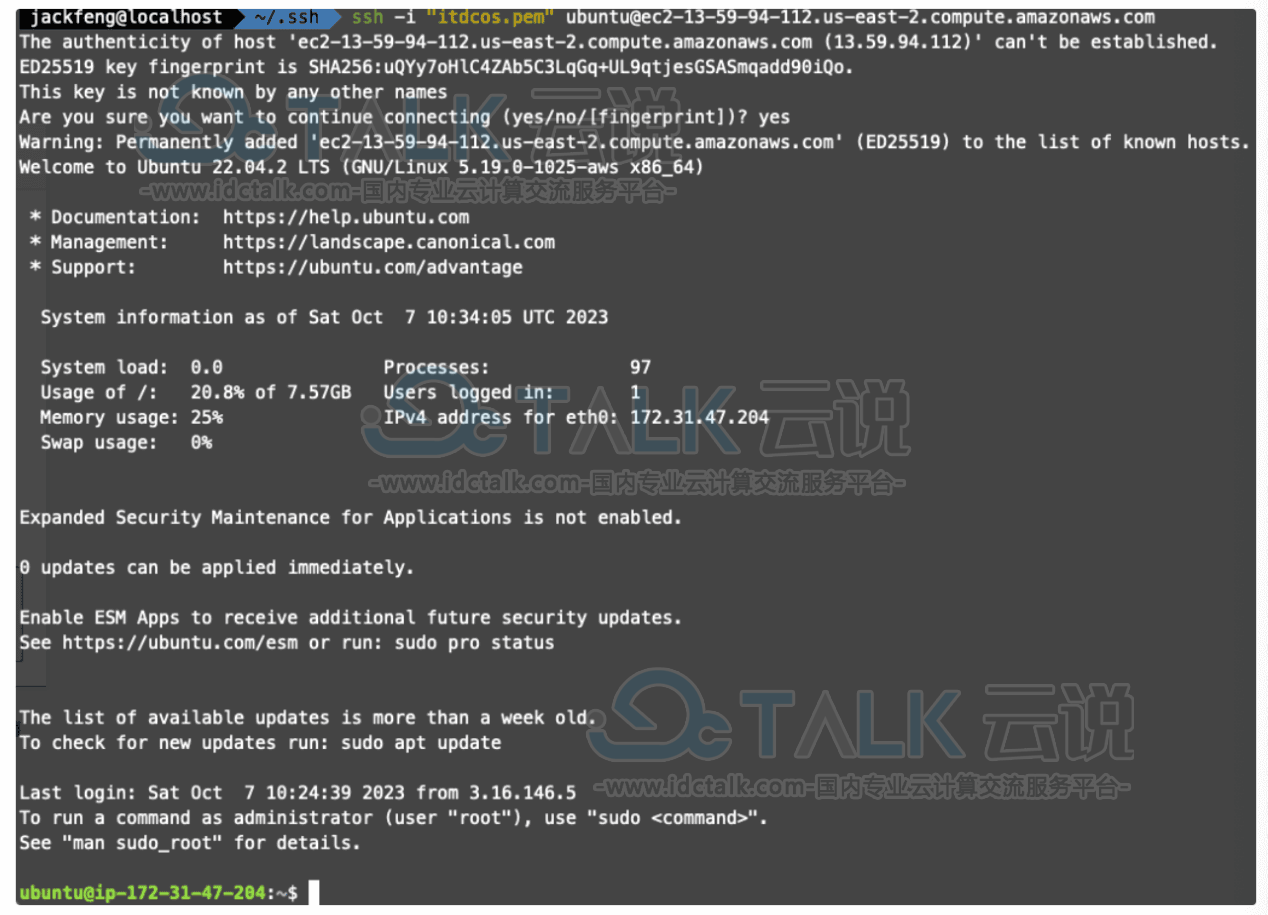

6、连接到Amazon EC2

一旦实例启动,用户需要通过SSH连接到云服务器。

```bash ssh -i key.pem user@public_ip_address

``key.pem``是我们在步骤一中生成的密钥对文件,``user``是连接服务器的用户名,``public_ip_address``是云服务器的公共IP地址。 ### 步骤三:安装依赖包 连接到云服务器后,我们需要安装一些必要的依赖包。这里我们使用``pip``来安装依赖包。 ```markdown ```bash pip install tensorflow==2.5.0 pip install transformers==4.7.0 pip install torch==1.9.0 pip install flask==2.0.1 pip install flask-cors==3.0.10

相关推荐:《Amazon EC2启动和连接实例的具体操作教程》

二、安装并部署ChatGPT模型

1、ChatGPT模型可以通过Hugging Face的模型库进行下载,本文将使用microsoft/DialoGPT-medium模型。

from transformers import GPT2LMHeadModel, GPT2Tokenizer tokenizer = GPT2Tokenizer.from_pretrained("microsoft/DialoGPT-medium") model = GPT2LMHeadModel.from_pretrained("microsoft/DialoGPT-medium")

2、使用Flask框架来创建一个简单的聊天API。

from flask import Flask, jsonify, request from flask_cors import CORS app = Flask(__name__) CORS(app) @app.route('/chat', methods=['POST']) def chat(): user_input = request.json['user_input'] input_ids = tokenizer.encode(user_input, return_tensors='pt') response = model.generate(input_ids, max_length=100) response_text = tokenizer.decode(response[0], skip_special_tokens=True) return jsonify({'response': response_text}) if __name__ == '__main__': app.run(host='0.0.0.0', port=5000)

3、通过运行下面的命令来启动API服务。

```bash python app.py

以上就是在亚马逊Amazon EC2上快速部署ChatGPT模型的全部流程,还是比较简单的,接下来用户就可以进行其他操作了。