一家名为Groq的初创公司在AI圈爆火,其在同名模型启动器上运行的大模型,能够每秒输出近500个token,输出速度比Gemini快10倍,比GPT-4快18倍。

目前,演示界面上有两种模型可以选择:Mixtral8x7B-32k,Llama 270B-4k。与此同时,Groq API也向开发者提供,完全兼容OpenAI API。

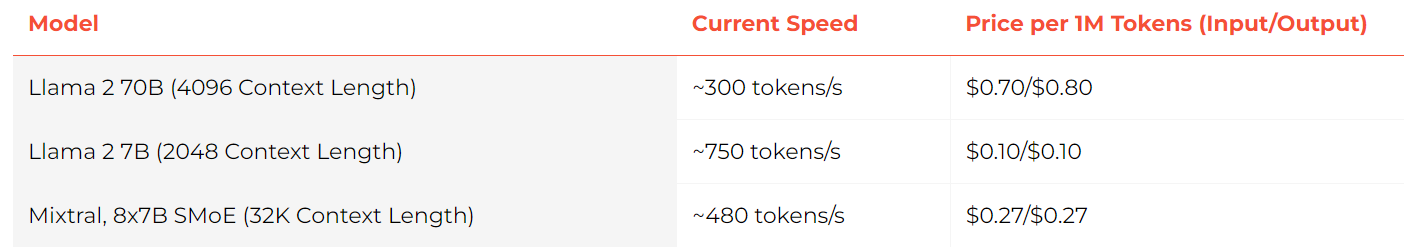

Mixtral 8x7B SMoE可以达到480 token/S,100万token价格为0.27美元。极限情况下,用Llama2 7B甚至能实现750 token/S。

价格方面,他们保证:一定低于市面上同等价格。

Groq突然爆火,背后最大的功臣不是GPU,而是自研的LPU——语言处理单元。

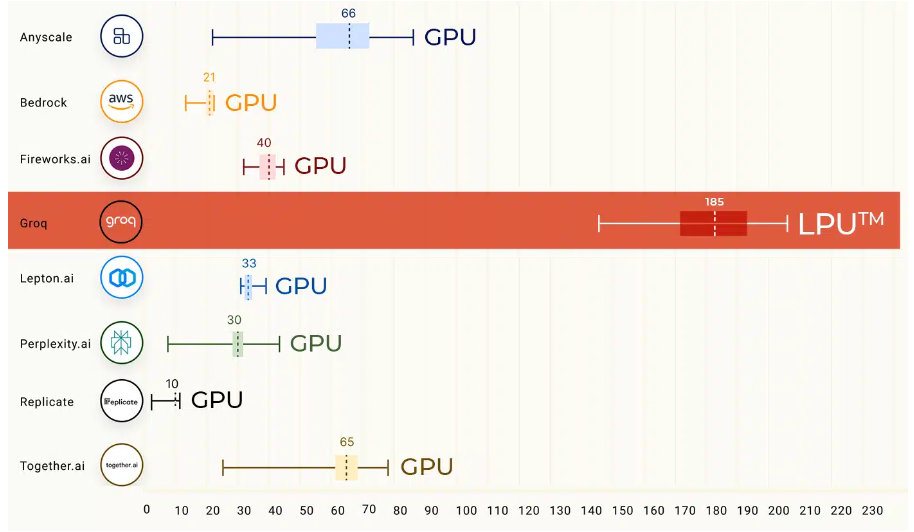

LPU的核心奥义是克服两个LLM瓶颈——计算密度和内存带宽。在前段时间的基准测试中,Groq LPU推理引擎上运行的Llama 2 70B直接刷榜,而且比顶级云提供商快18倍的LLM推理性能。

Groq火箭般的生成速度,让许多人为之震惊。Groq完全实现了远程实时的AI对话。在GroqInc硬件上运行Llama 70B,然后在提供给Whisper,几乎没有延迟。

Groq模型之所以能够以惊人速度响应,是因为背后公司Groq(同名)开发了独特的硬件——LPU。它是专为图形渲染而设计、包含数百个核心的并行处理器,能够为AI计算提供稳定的性能。

具体来说,LPU采用了时序指令集计算机(Temporal Instruction Set Computer)架构,这意味着它无需像使用高带宽存储器(HBM)的GPU那样频繁地从内存中加载数据。这一特点不仅有助于避免HBM短缺的问题,还能有效降低成本。这种设计使得每个时钟周期(every clock cycle)都能被有效利用,从而保证了稳定的延迟和吞吐量。在能效方面,LPU也显示出其优势。通过减少多线程管理的开销和避免核心资源的未充分利用,LPU能够实现更高的每瓦特计算性能。

目前,Groq可支持多种用于模型推理的机器学习开发框架,包括PyTorch、TensorFlow和ONNX。但不支持使用LPU推理引擎进行ML训练。

对于未来AI应用的服务而言,LPU可能会带来与GPU相比巨大的性能提升!