近期,微软和清华的研究人员联合发布了一种专用于个性对话Agent的记忆构建和检索的创新方法,SECOM。

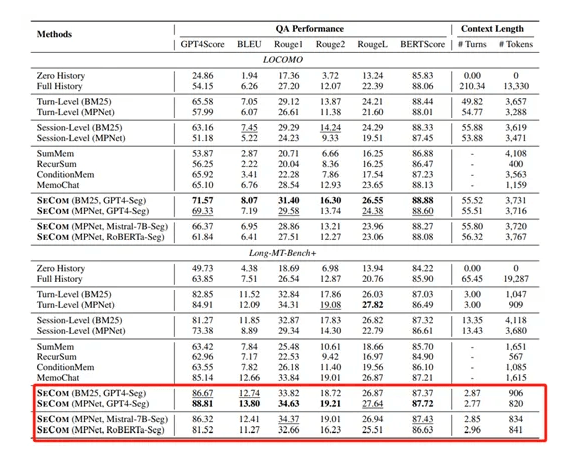

研究人员在LOCOMO和Long-MT-Bench+两个超复杂数据集上进行了综合评估,结果显示,在LOCOMO数据集上,SECOM的GPT4-Score达71.57,比全历史方法(54.15)高17.42分,比轮次级方法(65.55)高6.02分。而在Long-MT-Bench+中,其88.81分的表现更是让会话级方法(73.38)相形见绌。这些数字背后,是SECOM在“记忆精准度”和“语义完整性”上的双重突破。

SECOM的核心组件之一就是对话分割模型,主要负责将长期对话分解为语义连贯段落。

这一过程并非简单的文本切分,而是基于对对话内容的深度语义理解,识别出对话中话题的转换点,从而将对话自然地划分为多个主题相关的单元。这可以有效避免传统轮次级或会话级记忆构建方法中存在的问题,例如,轮次级记忆的碎片化和会话级记忆的冗余信息过多。

SECOM使用了GPT-4作为其对话分割的骨干模型。可在零样本学习的情况下对对话内容进行分析,并输出分割后的段落。

这种分割方法有两个巨大技术优势:第一,避免了传统有监督学习方法中需要大量标注数据的限制。零样本分割方法无需依赖标注数据,直接利用模型的预训练知识进行分割,大大降低了数据准备的成本和难度。第二,零样本分割能够更好地适应开放域的对话场景。由于没有受到特定领域或特定数据集的限制,GPT-4能够凭借其广泛的知识和语言理解能力,对各种类型的对话进行有效的分割。使得SECOM的对话分割模型能够广泛应用于各种不同的对话场景,而无需针对每个场景单独训练模型。

SECOM的另一个重要模块就是自反思机制,引入这个模块是为了进一步提升分割的准确性和一致性。SECOM会首先以零样本的方式对一批对话数据进行分割,然后根据标注数据中的真实分割结果,识别出分割错误的部分。然后会分析这些错误,反思其原因,并据此调整分割策略。

这一过程有点类似于人类在学习过程中的自我反思和改进。通过不断地分析错误、总结经验并调整方法,模型能够逐步提高其分割的准确性。这种自反思机制不仅能够提升分割的准确性,还能够使模型的分割结果更符合人类标注者的偏好。换句话说,能使模型的分割行为更贴近人类对对话结构的理解和划分方式。同时自反思机制的引入还带来了一个额外的好处,模型能够在少量标注数据的情况下快速适应新的领域或任务。

微软与清华联合发布的SECOM,不仅解决了长期交互的“记忆碎片化”难题,更展示了技术突破如何从实验室走向现实。