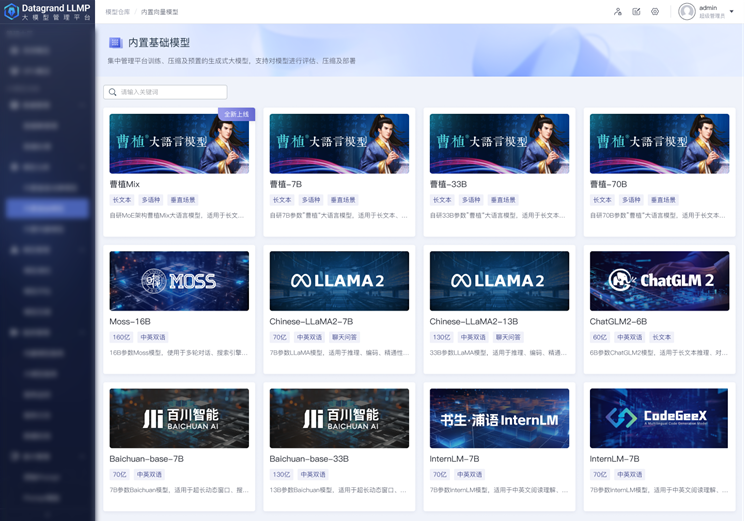

最近,达观大模型管理平台上线了两大全新功能。除了更大参数量级的70B曹植模型,更重量级的是上线全新曹植MoE模型,独家支持在平台上完成MoE大模型私有化部署、一键训练,支持用户对曹植MoE模型进行和常规模型同样的SFT微调、模型量化(支持INT8、INT4、INT3、INT2)、封装服务接口、Prompt指令定制等运维流程。

曹植MoE模型不光支持多语种,而且全面支持中文(Mixtral 8x7B不支持中文),并在中文场景做了针对性的训练优化,使得模型在长文本、多语种或众多垂直场景中发挥出更优、更强劲的性能。

自GPT-4问世以来,人们一直惊艳于它强大的涌现能力,包括出色的语言理解能力、生成能力、逻辑推理能力等等,这些能力让GPT-4成为机器学习领域最前沿的模型之一,然而,OpenAI至今未公开GPT-4的任何技术细节,训练单个拥有巨大参数(千亿甚至万亿级别)的大模型需要耗费最大人力和财力,只有少数巨头公司才有财力物力能够独立完成。

随着MoE架构的崭露头角,我们看到了一种新的可能性,即通过组合多个中等规模的模型,同样能够达到更大模型的效果。最近在大模型开源社区中备受瞩目的,除了采用与Gemini相同技术构建的Gemma,另一个备受关注的模型便是Mixtral 8x7B。这个由一家法国公司推出的新架构模型在推出后迅速引起了巨大的讨论。

Mixtral 8x7B是基于编码器(Decoder-Only)架构的稀疏专家混合网络(Sparse Mixture-Of-Experts,SMoE)开源大语言模型,使用Apache 2.0协议发布。它的独特之处在于对于每个token,路由器网络选择八组专家网络中的两组进行处理,并且将其输出累加组合,因此虽然Mixtral 8x7B拥有总共47B的参数,但每个token实际上只使用13B的活跃参数,推理速度与13B模型相当。

Mixtral 8x7B支持多种语言,包括法语、德语、西班牙语、意大利语和英语(注:Mixtral有个明显弊端为不支持中文),支持的上下文长度为32K token,并且在所有的评估的基准测试中均达到或优于Llama-2-70B和GPT-3.5,特别是在数学、代码生成和多语言基准测试中,Mixtral大大优于Llama-2-70B。

最令人瞩目的是,Mixtral 8x7B用更少的参数量就达到了Llama 2和chatGPT3.5的水平。这一突破性的进展引发了业界的广泛关注,许多专业人士纷纷表示,MoE架构的出现将在未来产生深远的影响。既然MoE架构能力这么出众,那么什么是MoE?

MoE即Mixture of Experts-专家混合模型,2013年12月,第一篇提出在神经网络中应用MoE的论文是《Learning Factored Representations in a Deep Mixture of Experts》。2017年1月,Google Brain团队发表论文《Outrageously Large Neural Networks:The Sparsely-Gated Mixture-of-Experts Layer》,真正意义上将MoE应用到超大参数规模模型之上。

MoE架构的核心思想是将模型分为若干个专家模块,每个专家负责处理数据的一部分。而后,一个门控机制负责动态选择哪个专家模块应该负责当前输入数据。这种模块化的结构不仅有效减少了模型的参数规模,还提高了模型的灵活性和泛化能力。

MoE最关键的组件

- 专家(Expert):MoE层由许多专家、小型MLP或复杂的LLM(如Mistral 7B)组成。

- 路由器(Router):路由器确定将哪些输入token分配给哪些专家。

路由策略有两种:token选择路由器或路由器选择token。路由器使用softmax门控函数通过专家或token对概率分布进行建模,并选择前k个。

每个专家都可以专门处理不同的任务或数据的不同部分。MoE构架能向LLM添加可学习参数,而不增加推理成本。可以利用稀疏矩阵的高效计算,并行计算所有专家层,以有效利用GPU的并行能力。帮助有效地扩展模型并减少训练时间。以更低的计算成本获得更好的结果!

在当前的技术发展趋势下,MoE架构很可能在2024年成为主流。Mixtral 8x7B的成功表明,MoE架构能够在不损失性能的前提下,显著降低训练和推理的资源成本。除了Mixtral 8x7B,还有许多其他公司和研究机构也在积极探索MoE架构的潜力。随着对该技术的深入理解和不断改进,MoE模型将逐渐取代传统的大型模型,成为各类应用领域的首选。

用户可在达观大模型管理平台LLMP上完成MoE模型微调的数据集管理、模型SFT微调,服务封装上线、Prompt指令自定义等运维流程。

达观大模型管理平台LLMP是一款可为各种类GPT模型提供模型优化的全方位工具。它以降低模型优化门槛、提高用户体验为目标,为企业用户提供了一站式的模型管理解决方案。

通过提供这一系列、全方位的功能和特性,“曹植”大模型管理平台成为一款强大的大语言模型运营和管理工具,为企业用户在知识对话、智能写作、文本生成领域带来了更高效、更便捷的模型管理体验。